ControlNetのdw_openposeをの使い方

とみます(@20tomimasu)です。

Openposeの新しいタイプ「dw_openpose_full」が公開されたようなので、

Stable Diffusion web UI のControlNetで使ってみました。

棒人間の描写精度が向上していますね。

6か月でここまで進歩するのか…すごい。

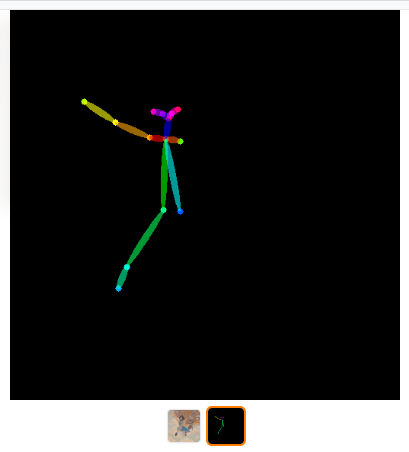

ControlNetのopenpose、6か月前との比較

>>StableDiffusionのControlNetの始め方・使い方

↑当時、openposeがリリースされたときのブログを読み返している。

棒人間で、描写する人間のポーズなどを指定できた。

それが、今では↓

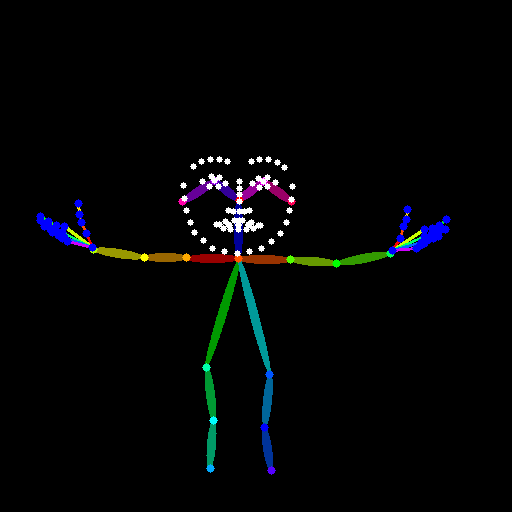

このレベルに。(ぱっと見は恐いw)

顔の表情や手の指1本まで、表現できるのか…

すごい進歩で。

実際に、試してみよう。

WEB UIでのdw_openposeの使い方

この方のnoteが分かりやすかった。

>>(AIイラスト)controlNETの新Preprocessor「dw openpose」を紹介(stable diffusion)

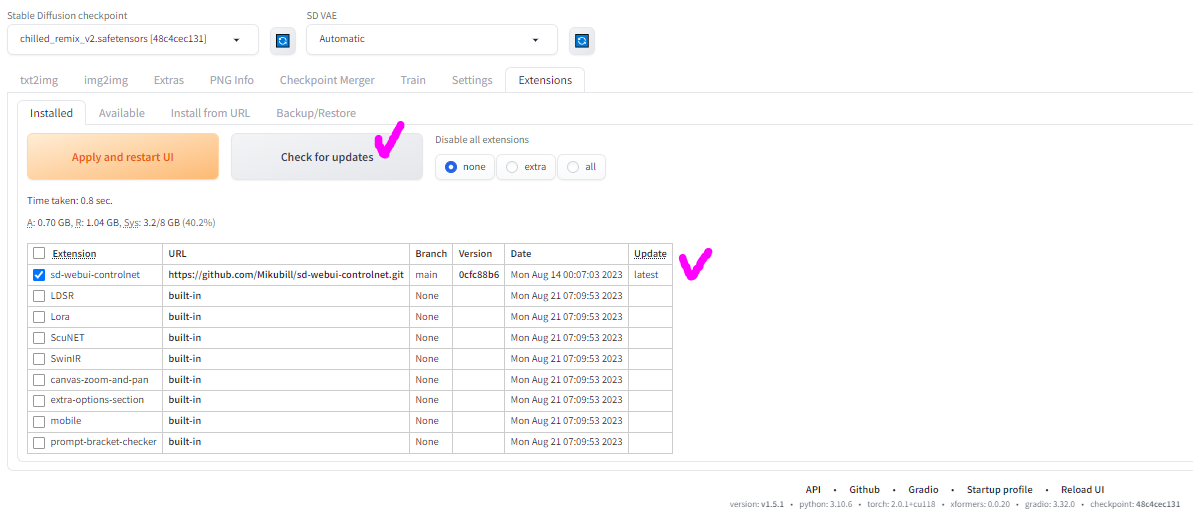

- WEB UIのアップデート

- ControlNetのdw_openpose_fullを有効化させる

- img2imgで棒人間の生成

- プロンプトで指定ポーズのAIイラストを生成

以下、画像を用いて↓

↑Extensionsより、webuiをアップデートする。

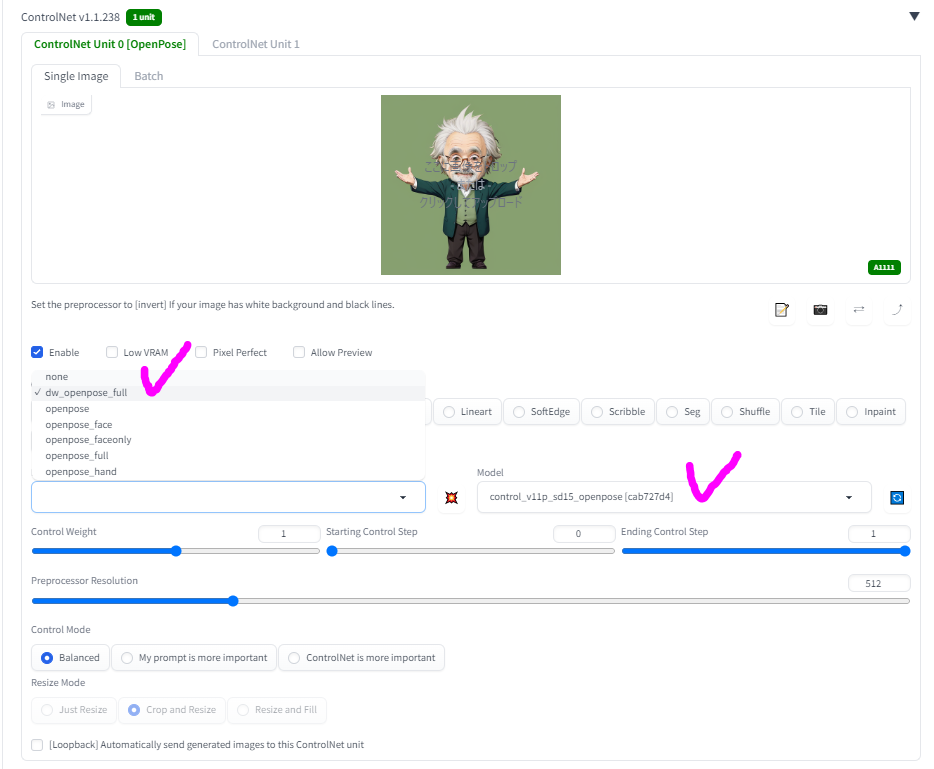

↑今回、試しに、過去に生成した画像を用いていく。通称、チビアイン。

↑dw_openpose_fullが表示されたので、これを選択する。

ついでに、モデルを用意して無かったので、ここからダウンロードした↓

いざ、生成‼

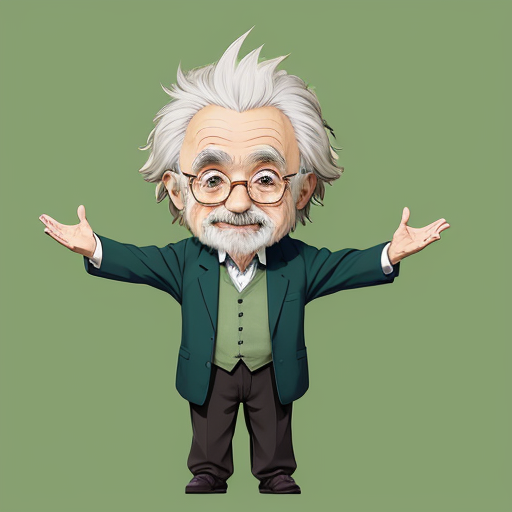

↑おぉー、忠実に表現されている。

プロンプトに、

- a yellow cat

- negative) EasyNegative

だけで、100枚ほど生成すると…

↑ポーズが破綻していない、AIイラストも生成できた。

ただ、打率的には、10枚に1枚くらいで、指などの表現は、難しいみたい。

おそらく、今回用いたチビアインの指先が重なっていたので、

AIによる読み取り→表現がキツかったのだろう。

もう少し、別のポーズでも挑戦してみようかな。

ちなみに、失敗例として、飛行機ポーズなんかもw

びゅいーん。

おわりに

以上「ControlNetのdw_openposeをの使い方」でした。

イラスト生成AIのコマンド指示などの精度が日々向上しており。

相変わらず、発展の速い世界で。

1日1%の自分アップデートを続けて、レイワの発展をフォローしていきましょう。

それでは、また。